Google enrichit sa panoplie de rich snippets

-Le rich snippet Produit (prix, moyenne des notes et nombre d'évaluateurs) est disponible en France.

- Amélioration de l'outil de test des rich snippets : en plus de la soumission d'une URL, on peut maintenant fournir du code brut pour voir ce que Google est capable d'en extraire.

L'outil de test est disponible à l'adresse : https://www.google.com/webmasters/tools/richsnippets

Source : Abondance

Cela commence par les rich snippets classiques, pour permettre aux internautes de voir ce que la communauté pense de vous et vos produits, c'est à dire de se faire un avis sur vos produits et services sans quitter votre site. Cela va jusqu'aux dates de vos événements, ou à la balise "Auteur" de Google+, stratégique si pour devenir un "expert". Il y aura par la suite d'autres fonctionnalités à rajouter dans votre site.

AdWords pour les vidéos

L'utilisateur n'a qu'à télécharger son clip publicitaire depuis l'interface d'AdWords, définir une cible (mots clés utilisés dans le moteur, ou thèmes particuliers), et le prix maximal pour chaque publicité visionnée. Il ne paie que si la publicité est visionnée entièrement (c'est un peu l'équivalent du coût "au clic" d'AdWords). Des outils de suivi permettent de savoir combien de personnes ont regardé la publicité, combien ont cliqué, combien ont visionné une autre publicité de la même campagne, et combien se sont inscrits à la chaîne vidéo de l'annonceur.

Source : WebRankInfo

Si vous investissez dans 1 vidéo, pensez que celle-ci ne sera pas visible uniquement sur votre site, mais aussi sur les réseaux sociaux... et pourquoi pas dans une publicité ciblée sur YouTube, avec ses 800 millions de visiteurs unique chaque mois !

GoldenMarket peut vous aider à réfléchir en ce sens. La vidéo sur Internet fait partie de l'avenir. Ne vous laissez pas trop distancer.

Nouvel algorithme Google : Penguin

- Les titres : répétition systématique des mots clés de la page dans tous les titres h1, h2, h3... / bourrage de mots clés dans la balise title

- Le contenu : bourrage de mots clés, textes incohérents ou copiés de sources externes. Trop de publicités au-dessus de la ligne de flottaison.

- Les liens internes : trop de liens sortants vers des sites de mauvaise qualité / liens internes utilisant toujours la même ancre (si celle-ci est une expression clé)

- Les liens externes (backlinks) : trop de backlinks venant de pages hors sujet / trop de backlinks venant de signatures de forums / trop de backlinks venant de sites rédigés dans une langue étrangère / trop de backlinks venant de sites appartenant au même propriétaire et reliés entre eux (réseaux de sites trop visibles) Source : WebRank Info

Rien de très nouveau en réalité, à part un affinage de critères qui existent déjà depuis longtemps chez Google, et qui visent à la pertinence des résultats. Concernant le contenu, vous n'avez donc rien à changer dans vos pratiques de rédaction ; continuez à écrire en bon français des informations de qualité et originales.

Concernant les liens, il sera peut-être nécessaire de vérifier qui sont vos partenaires, et comment sont conçus leurs sites web (même si la notion "site de mauvaise qualité" est assez floue). Pour les backlinks, nous avons devancé Google en effectuant il y a quelque temps une refonte de notre annuaire pour le rendre plus qualitatif (lien "Club GM" ou "Club Goldenmarket" dans les pieds-de-page des sites).

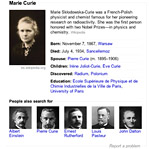

Google officialise le lancement de son moteur sémantique

- Résumé et informations connexes : quelques lignes de texte et des photos permettant d'obtenir des informations dès la page de résultats (une date de naissance, la photo d'un événement...)

- Propositions de liens : quelques liens se rapportant à la requête, pour l'approfondir ou l'ouvrir sur des sujets connexes

- Désambigüisation de la requête : dans les cas où l'expression tapée par l'internaute peut désigner des entités différentes (Opéra, le spectacle / Opéra, le navigateur web)

Source : Abondance

La balise auteur est de plus en plus importante

Source : Abondance

Nous avons réalisé un tutoriel pour vous guider dans ce processus ; il est accessible librement ici : Tutoriel Google+

Bing propose un outil pour désavouer les backlinks

| Il y a quelques semaines, Google annonçait la prochaine disponibilité d'un outil permettant de révoquer des backlinks pour éviter le "negative SEO", c'est à dire la pollution volontaire d'un site par des concurrents, via la création de backlinks de mauvaise qualité. Au final, c'est Bing qui propose la fonctionnalité le premier (dans les Bing webmaster tools). |

| Source : WebRank Info |

Attention, les backlinks sont un des plus gros piliers du référencement naturel, il est forcément risqué d'en désavouer un ou plusieurs. Cette opération a surtout du sens dans le cadre du nouvel algorithme de Google, Pingouin, qui est plus strict sur la cohérence entre les backlinks et le contenu de votre site (si tous vos backlinks proviennent de sites n'ayant aucun rapport avec votre domaine d'activité, il y a un problème). Dans ce cas, il peut être intéressant de demander à Google de ne pas tenir compte de certains liens (que ceux-ci aient été créés par des concurrents malveillants, essayant de dégrader votre référencement naturel, ou simplement de liens depuis des commentaires de blogs, etc.)

Désavouer un backlink dans les Bing Webmaster Tools ne joue évidemment pas sur la prise en compte par Google. Puisqu'il a été annoncé officiellement, l'outil permettant de le faire chez Google devrait être bientôt disponible.

Bing fournit du contenu direct, grâce à l'encyclopédie Britannica

Rappelons que Google expérimente en ce moment un procédé similaire, appelé "knowledge graph", mais sans se limiter à une seule source d'information de référence (voir newsletter du mois dernier).

Source : WebRank Info

En puisant ses informations dans l'encyclopédie Britannica, Bing évite une partie du problème lié aux sources. Le moteur propose en effet des liens sortants vers des articles de Britannica, dont la réputation et le sérieux assurent un haut niveau de fiabilité. Au contraire, Google agrège le contenu de différentes sources et propose des liens vers d'autres requêtes sur son propre moteur. Dans tous les cas, avec la recherche sémantique, la question de la fiabilité des sources d'information devient très sensible et pourrait être un sérieux facteur de différenciation d'un moteur à l'autre.

La fin des 10 résultats par page de Google

Source : Abondance

En réduisant ainsi le nombre de résultats "naturels", Google surexpose ses liens Adwords et fait augmenter leur taux de clic. A première vue, il s'agit donc d'une stratégie destinée à accroître les revenus publicitaires. Mais il est surprenant de constater que pour la première fois, Google est ouvertement prêt à sacrifier la pertinence au profit de la publicité, c'est à dire de réduire l'importance du référencement naturel par rapport aux Adwords. A moins qu'il n'y ait une autre vision stratégique encore peu perceptible derrière ce choix, cela ressemble à un changement de politique interne.

Si l'on tient compte, en parallèle des modifications induites par la mise en place du Knowledge graph, qui dispense l'internaute de sortir de Google pour obtenir une réponse à sa requête (voir revues de presse précédentes et Club Golden), on conçoit facilement que la façon de gérer la promotion d'un site web risque de changer profondément dans les temps qui viennent.

Google : un brevet pour piéger les référenceurs

Ces périodes de test pourraient durer entre 20 et 70 jours.

Source : Abondance

Rien ne dit que ce brevet est déjà utilisé par Google, ni même s'il le sera un jour. Toutefois des périodes de yoyo dans les SERPs sont parfois constatées, au cours de la vie d'un site web, sans qu'on parvienne à trouver une explication logique. Ce pourrait être lié.

Dans tous les cas, la conclusion est claire : la bonne stratégie n'est pas de tenter de décrypter les manipulations de l'algorithme de Google et d'y répondre au coup par coup, en fonction de l'évolution du classement des pages, mais de se tenir à une stratégie de création de contenu à forte valeur ajoutée. C'est le coeur de toutes les problématiques de référencement naturel.

Yahoo envisagerait de rompre avec Microsoft

En effet, depuis plusieurs années, Yahoo! utilisait le moteur Bing de Microsoft pour ses recherches et sa régie publicitaire. Cet accord ne donnerait plus satisfaction à Yahoo!

Source : Abondance

A savoir également : si le partenariat avec Microsoft prend fin, Yahoo! pourrait se tourner vers Google pour son moteur de recherche et sa régie. Ce serait un très gros coup dur pour les activités online de Microsoft.

Changement d\'algorithme Google : vers la sémantique

Cette mise à jour modifiera le type de réponses apportées par le moteur Google. En se concentrant sur le sens du contenu (ce que l'on nomme sémantique) plutôt que sur la densité des mots clés et des backlinks, le moteur devrait être capable de fournir d'emblée des réponses "intelligentes" plutôt que les traditionnelles listes de sites web.

Source : WebRankInfo

On ne sait pas encore quel type de requêtes sera touché, ni comment sera amené ce gros changement (qui s'éloigne de plus en plus de la conception classique d'un moteur de recherche web, et s'approche de ce que propose par exemple le moteur Wolfram|Alpha), mais une chose est certaine, c'est que Google restera toujours à la recherche de la pertinence. Continuez donc d'écrire du contenu original à forte valeur ajoutée, c'est le meilleur moyen d'être prêt pour la mise à jour, quelle que puisse être sa forme.

Critères de référencement de Google Maps

- La catégorie de votre établissement est "plus large" que la catégorie recherchée par l'internaute (exemple, si la requête est "pizzeria" et que la catégorie de votre établissement est "restaurant")

- La catégorie recherchée par l'internaute apparaît dans le nom de votre établissement ("Rocky's pizzeria" pour une recherche de pizzeria)

- Vous avez au minimum 5 avis Google sur votre fiche établissement

- Le nom de la catégorie recherchée par l'internaute se trouve dans un avis Google ("pizzeria")

- Le nom de la catégorie recherchée par l'internaute se trouve dans la description de votre établissement

Source : SearchEngineLand

Le référencement dans Google Maps est relativement négligé alors qu'il prend de plus en plus d'importance avec la croissance du web mobile et de la localisation. Nous conseillons à tous nos clients, quel que soit leur domaine d'activité, de créer une fiche Google Maps pour leur établissement (contactez votre chef de projet si vous souhaitez des précisions). Les informations apportées par cet article seront utiles pour en faire plus que le minimum vital.

12 à 13% de requêtes Google masquées en France

Depuis quelques semaines, Google crypte les requêtes des internautes connectés à son service, ce qui les rend inutilisables par les logiciels de suivi de statistiques (y compris Google Analytics).

Une étude de la société AtInternet estime qu'en France, 12 à 13% des requêtes sont ainsi devenues inconnaissables. Dans votre outil de suivi statistique, ces requêtes seront groupées sous le terme "not provided".

Google justifie ce cryptage par la volonté de protéger la vie privée de ses utilisateurs. A noter qu'il est toujours possible de connaître le top 1000 des mots clés les plus apporteurs de trafic sur les 30 derniers jours, en passant par les Webmaster tools (mais on perd les informations de conversion).

Puisqu'il cumule toutes les requêtes des utilisateurs connectés à Google, le groupe « not provided » risque de devenir l'un des « mots clés » les plus fréquents dans les outils d'analyse. On peut toutefois estimer qu'il contient les mêmes mots clés, dans les mêmes proportions, que tous ceux qui sont restés visibles.

La CNIL s'inquiète des nouvelles CGU de Google

Retour sur 1 année de Panda

Bing socialise ses résultats

Plus de 4 mots clés en moyenne dans les requêtes moteur

Google pénalise les pages proposant trop de publicité

Source : Abondance

Obtenir les résultats Google les plus neutres possibles

Source : SEOmoz

"Under the hood" : des informations sur le fonctionnement de Google

Source : Under the hood

Questions

Je pose une question